M1マックにmacOS(Sequoia)をクリーンインストールした際のメモです.参考になるAppleの公式ページはこちら.

Apple Silicon 搭載マックでは,以前のように再起動時に "command⌘ + R" を長押しするのではなく,再起動時に電源ボタンを長押しするとディスクユーティリティが起動します.

ユーティリティの一覧が表示されたら「ディスクユーティリティ」を選択して「続ける」をクリックします.

ディスクユーティリティのサイドバーの「内蔵」セクションで「Macintosh HD」という名前のボリュームが表示されていることを確認して,サイドバーで「Macintosh HD」を選択します.

ツールバーの「消去」ボタンをクリックして,名前(Macintosh HD)とフォーマット(APFS)を指定します(ここは設定を変更せずにそのままとしました).

「消去」をクリックします。「ボリュームグループを消去」が代わりに表示される場合は、このボタンをクリックします.

ハードディスクの内容が消去されたあとは,購入時のOSをインストールすることになるので,それを選択して,終了後に最新のOS(今回は Sequoia )にアップグレードしました.

OS (Sequoia) のクリーンインストール後にインストールしたアプリケーションは,以下です.

- Adobe Creative Cloud https://x.gd/u5xXk からインストーラーをダウンロード

- App Cleaner https://freemacsoft.net/appcleaner/ からインストーラーをダウンロード

- Evernote https://evernote.com/ja-jp/download からインストーラーをダウンロード

- Google Chrome https://x.gd/KgOIk からインストーラーをダウンロード

- Discord https://discord.com/download からインストーラーをダウンロード

- Homebrew - gnuplot, Julia, Jupyter Notebook, LaTeXiT, Octave, R Studio, TeX Shop.

- iMovie App Store からインストール

- Keynote App Store からインストール

- LINE https://www.line.me/ja/download からインストーラーをダウンロード

- Messenger https://www.messenger.com/desktop からインストーラーをダウンロード

- mi https://www.mimikaki.net/ からインストーラーをダウンロード

- Microsoft 365

- R CRANからインストーラーをダウンロード

- R Studio RStudioのダウンロードサイトからインストーラーをダウンロード

- Teams

- Visual Studio Code https://code.visualstudio.com/download からインストーラーをダウンロード(Visual Studio Code のExtensionはとりあえず fortran, Gnuplot, Julia, Octave, Pythonの5つにしました.)

- Zoom https://zoom.us/ja/download からインストーラーをダウンロード

これらのアプリケーションのうち,Homebrew経由でインストールしたものに関して,以下にメモを残します.

まずは,Homebrewのインストールですが,公式サイトにあるように以下のターミナルからコマンドを実行します.

% /bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

この後に,以下のようにPathを通すと"brew"コマンドが使用できるようになります.以下の例はPathを通した後に,Homebrewのバージョンを確認した例です.

% echo 'eval "$(/opt/homebrew/bin/brew shellenv)"' >> /Users/(username)/.zprofile

% eval "$(/opt/homebrew/bin/brew shellenv)"

% brew -v

Homebrew 4.4.32

上記の1行目のコマンドの (username) にはアカウントのユーザー名が入ります.

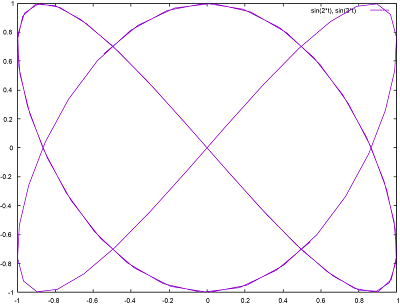

gnuplot のインストール

% brew install gnuplot

Julia のインストール

ターミナルから以下のコマンドを実行します.

% brew install --cask julia

インストールが終了したら,パッケージモード("]"キーを押す)に切り替えて,以下のパッケージをインストールしておきます.

(@v1.11) pkg> add IJulia

(@v1.11) pkg> add CSV

(@v1.11) pkg> add Combinatorics

(@v1.11) pkg> add DataFrames

(@v1.11) pkg> add Distributions

(@v1.11) pkg> add JuMP

(@v1.11) pkg> add Plots

(@v1.11) pkg> add PyCall

(@v1.11) pkg> add PyPlot

(@v1.11) pkg> add RDatasets

(@v1.11) pkg> add StatsBase

(@v1.11) pkg> add StatsPlots

(@v1.11) pkg> add SumOfSquares

(@v1.11) pkg> add Statistics

(@v1.11) pkg> add Gadfly

(@v1.11) pkg> add LinearAlgebra

インストールされているパッケージを確認するには"status"コマンドを使用します.

(@v1.11) pkg> status

Jupyter Notebookのインストール

j% brew install jupyter

インストールが完了したら,以下のコマンドでJupyter Notebookを立ち上げてみます.

% jupyter notebook

先述の「Juliaのインストール」のところで示した"IJulia"パッケージがインストールされているとJupyter Notebook の右上の"New"ボタンを押すと,以下のようにJuliaが選択できるようになっているはずです.

Octave のインストール

Command Line Toolsがインストールされているとは知りつつも,一応確認しておきます.

% sudo xcode-select --install

Password:

xcode-select: note: Command line tools are already installed. Use "Software Update" in System Settings or the softwareupdate command line interface to install updates

最新版をインストールしたばかりなのですが,一応確認しておきます.

% brew update

==> Updating Homebrew...

Already up-to-date.

これまた同様に,一応確認です.

% brew upgrade

続いて Octave のインストールを行います.

ズラズラとインストールが始まり,終了したら,Ocrave を立ち上げてみます.

今回のインストールでは,

以前の投稿で生じたエラー(.config フォルダ内に octave フォルダが存在しないという内容)は出ませんでした.

R のインストール

今回は,インストーラーパッケージを使用してインストールしました.Homebrew経由でインストールするには,以下のコマンドを実行します.

% brew install --cask r

XQuartzのインストールは,以下のコマンドを実行します(いまだにXQuartzが必要なのかどうかはわかりませんが...).

% brew install --cask xquartz

R Studio のインストールは,以下のコマンドを実行します.

% brew install --cask rstudio

TeX Shop のインストール

ターミナルから以下のコマンドを実行します.

% brew install --cask mactex

ちなみに,GUIが不要な場合は以下のコマンドを実行します.

% brew install --cask mactex mactex-no-gui

インストールが終了したら,GUIの要,不要に関わらず,パスを確認しておきます.以下のコマンドを実行して,/Library/TeX/texbin が含まれていることを確認します.

% echo $PATH

/Library/TeX/texbin

パスなので,色々と書かれていますが,/Library/TeX/texbin が書かれていれば,大丈夫です.

含まれていない場合は,以下のコマンドを実行してパスを追加します.

% echo 'export PATH="/Library/TeX/texbin:$PATH"' >> ~/.zshrcsource ~/.zshrc

_cos_t_.png)